Log Loss và Cross Entropy thường được sử dụng thay thế cho nhau trong lĩnh vực học máy, đặc biệt là trong các bài toán phân loại. Tuy nhiên, liệu chúng có thực sự giống nhau? Bài viết này sẽ phân tích sâu về Log Loss và Cross Entropy, làm rõ sự khác biệt giữa hai khái niệm này và ứng dụng của chúng trong thực tế.

Sự Khác Biệt Giữa Log Loss và Cross Entropy

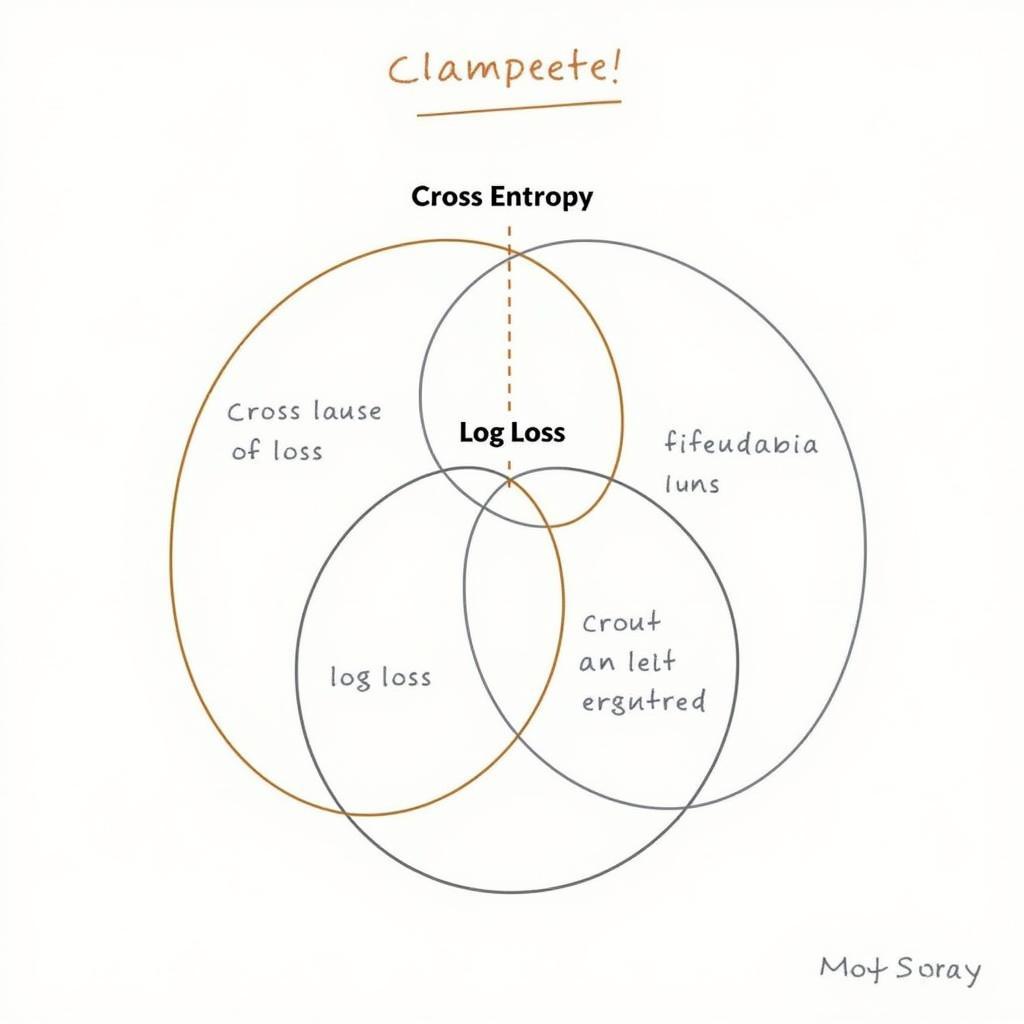

Mặc dù thường được sử dụng lẫn lộn, Log Loss và Cross Entropy có một sự khác biệt nhỏ nhưng quan trọng. Cross Entropy là một thước đo tổng quát hơn, được sử dụng để đánh giá sự khác biệt giữa hai phân phối xác suất. Log Loss, mặt khác, là một trường hợp đặc biệt của Cross Entropy khi áp dụng cho bài toán phân loại nhị phân. Nói cách khác, Log Loss là Cross Entropy được tính toán trên một phân phối xác suất thực tế và một phân phối xác suất dự đoán trong bài toán phân loại nhị phân.

So sánh Log Loss và Cross Entropy

So sánh Log Loss và Cross Entropy

Log Loss: Đo Lường Độ Chính Xác của Mô Hình Phân Loại Nhị Phân

Log Loss đo lường hiệu suất của một mô hình phân loại bằng cách tính toán mức độ sai lệch giữa phân phối xác suất dự đoán và phân phối xác suất thực tế. Giá trị Log Loss càng thấp, mô hình càng chính xác.

Công Thức Tính Log Loss

Công thức tính Log Loss như sau:

Log Loss = - (1/N) * Σ (y_i * log(p_i) + (1 - y_i) * log(1 - p_i))Trong đó:

- N là số lượng quan sát.

- y_i là giá trị thực tế (0 hoặc 1).

- p_i là xác suất dự đoán của lớp positive (1).

Cross Entropy: Đánh Giá Sự Khác Biệt Giữa Hai Phân Phối Xác Suất

Cross Entropy là một khái niệm tổng quát hơn, được sử dụng để đo lường sự khác biệt giữa hai phân phối xác suất, không chỉ giới hạn trong bài toán phân loại nhị phân.

Công Thức Tính Cross Entropy

Công thức tính Cross Entropy cho bài toán phân loại đa lớp như sau:

Cross Entropy = - Σ (y_i * log(p_i))Trong đó:

- y_i là giá trị thực tế (one-hot encoded).

- p_i là xác suất dự đoán cho lớp tương ứng.

Ứng Dụng của Log Loss và Cross Entropy trong Học Máy

Cả Log Loss và Cross Entropy đều được sử dụng rộng rãi làm hàm mất mát trong huấn luyện các mô hình học máy, đặc biệt là trong các bài toán phân loại. Chúng giúp tối ưu hóa mô hình bằng cách giảm thiểu sự khác biệt giữa dự đoán và giá trị thực tế.

Ví dụ về ứng dụng

- Phân loại email spam: Sử dụng Log Loss để đánh giá hiệu suất của mô hình phân loại email spam/không spam.

- Phân loại hình ảnh: Sử dụng Cross Entropy để huấn luyện mô hình phân loại hình ảnh với nhiều lớp (ví dụ: chó, mèo, chim).

“Log Loss và Cross Entropy là những công cụ quan trọng trong việc đánh giá và cải thiện hiệu suất của các mô hình học máy. Hiểu rõ sự khác biệt và ứng dụng của chúng sẽ giúp bạn lựa chọn hàm mất mát phù hợp cho từng bài toán cụ thể.” – Nguyễn Văn A, Chuyên gia Học Máy tại Đại học Bách Khoa TP.HCM.

Ứng dụng của Log Loss và Cross Entropy

Ứng dụng của Log Loss và Cross Entropy

Kết luận

Log Loss và Cross Entropy, mặc dù có sự khác biệt về mặt khái niệm, đều đóng vai trò quan trọng trong việc đánh giá và tối ưu hóa các mô hình học máy, đặc biệt là trong lĩnh vực phân loại. Hiểu rõ sự khác biệt này sẽ giúp bạn lựa chọn và sử dụng chúng một cách hiệu quả hơn.

FAQ

- Khi nào nên sử dụng Log Loss?

- Khi nào nên sử dụng Cross Entropy?

- Sự khác biệt chính giữa Log Loss và Cross Entropy là gì?

- Làm thế nào để giảm thiểu Log Loss và Cross Entropy?

- Log Loss và Cross Entropy có thể được sử dụng cho bài toán hồi quy không?

- Tại sao Log Loss và Cross Entropy thường được sử dụng làm hàm mất mát?

- Có những hàm mất mát nào khác tương tự Log Loss và Cross Entropy?

Mô tả các tình huống thường gặp câu hỏi.

Người dùng thường tìm kiếm thông tin về Log Loss và Cross Entropy khi họ đang tìm hiểu về học máy, đặc biệt là các bài toán phân loại. Họ muốn hiểu rõ sự khác biệt giữa hai khái niệm này, cách tính toán và ứng dụng của chúng trong thực tế.

Gợi ý các câu hỏi khác, bài viết khác có trong web.

- Hàm mất mát trong học máy là gì?

- Các loại hàm mất mát phổ biến trong học máy.

- So sánh các hàm mất mát khác nhau.