Adagrad và Adam là hai thuật toán tối ưu hóa phổ biến được sử dụng trong học máy để huấn luyện các mô hình học sâu. Việc lựa chọn thuật toán tối ưu có thể ảnh hưởng đáng kể đến tốc độ hội tụ và hiệu suất của mô hình. Bài viết này sẽ đi sâu phân tích sự khác biệt giữa Adagrad và Adam, giúp bạn đưa ra lựa chọn sáng suốt cho dự án tiếp theo.

Adagrad: Tự Động Điều Chỉnh Tốc Độ Học

Adagrad (Adaptive Gradient Algorithm) là một thuật toán dựa trên gradient descent, tự động điều chỉnh tốc độ học cho từng tham số trong quá trình huấn luyện. Adagrad sử dụng một learning rate chung cho tất cả các tham số, nhưng sẽ chia learning rate này cho căn bậc hai của tổng bình phương gradient của tham số đó từ tất cả các bước trước đó.

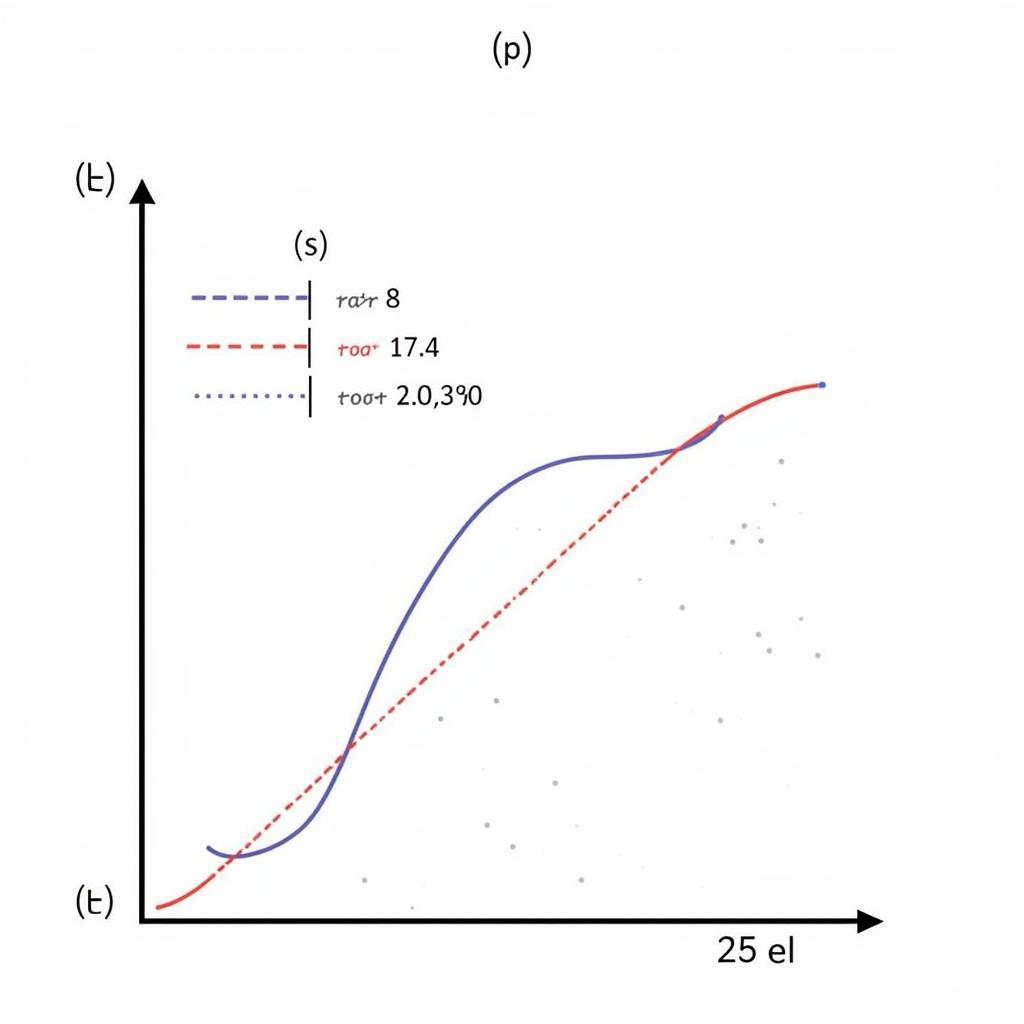

Điều chỉnh tốc độ học trong Adagrad

Điều chỉnh tốc độ học trong Adagrad

Điều này có nghĩa là các tham số có gradient lớn (thường được cập nhật nhiều) sẽ có learning rate giảm dần, trong khi các tham số có gradient nhỏ (ít được cập nhật) sẽ có learning rate tăng lên. Nhờ đó, Adagrad có thể hội tụ nhanh hơn trong không gian tham số thưa thớt.

Ưu điểm của Adagrad:

- Hiệu quả trong việc xử lý dữ liệu thưa thớt.

- Không cần điều chỉnh thủ công learning rate.

- Hội tụ nhanh trong giai đoạn đầu huấn luyện.

Nhược điểm của Adagrad:

- Learning rate giảm dần theo thời gian, có thể dẫn đến hội tụ chậm ở giai đoạn sau.

- Không phù hợp với các bài toán có gradient thay đổi liên tục.

Adam: Kết Hợp Momentum và Adaptive Learning Rate

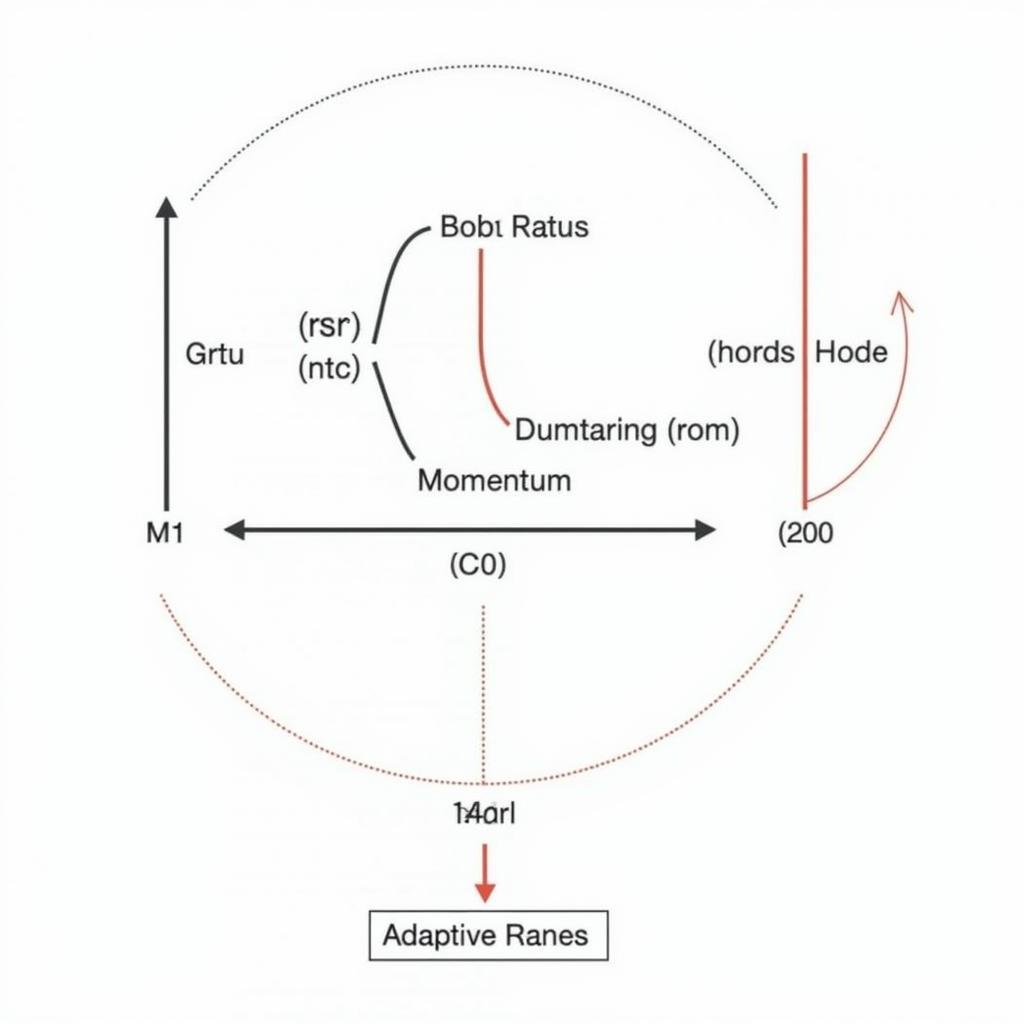

Adam (Adaptive Moment Estimation) là một thuật toán tối ưu hóa kết hợp giữa momentum và adaptive learning rate. Adam lưu trữ cả trung bình động của gradient (giống momentum) và trung bình động của bình phương gradient (giống Adagrad).

Cơ chế hoạt động của Adam

Cơ chế hoạt động của Adam

Thay vì sử dụng trực tiếp gradient hiện tại, Adam sử dụng momentum để làm mịn dao động của gradient và adaptive learning rate để điều chỉnh tốc độ học cho từng tham số.

Ưu điểm của Adam:

- Hội tụ nhanh chóng và ổn định.

- Hiệu quả trong nhiều bài toán học máy khác nhau.

- Ít nhạy cảm với việc lựa chọn learning rate ban đầu.

Nhược điểm của Adam:

- Có thể yêu cầu nhiều bộ nhớ hơn Adagrad.

- Khó điều chỉnh siêu tham số hơn Adagrad.

Khi Nào Nên Sử Dụng Adagrad và Adam?

Nên sử dụng Adagrad khi:

- Xử lý dữ liệu thưa thớt, chẳng hạn như trong bài toán recommend system hoặc xử lý ngôn ngữ tự nhiên.

- Cần hội tụ nhanh trong giai đoạn đầu huấn luyện.

Nên sử dụng Adam khi:

- Huấn luyện các mô hình học sâu phức tạp.

- Cần tốc độ hội tụ nhanh và hiệu suất tốt.

- Không muốn mất nhiều thời gian điều chỉnh learning rate.

Lời Kết

Cả Adagrad và Adam đều là những thuật toán tối ưu hóa mạnh mẽ và phổ biến trong học máy. Việc lựa chọn thuật toán phù hợp phụ thuộc vào đặc điểm của bài toán và tập dữ liệu. Hiểu rõ ưu nhược điểm của từng thuật toán sẽ giúp bạn đưa ra quyết định tối ưu cho dự án của mình.

Câu Hỏi Thường Gặp

1. Adagrad và Adam khác nhau như thế nào?

Adagrad và Adam đều là thuật toán adaptive learning rate, nhưng Adam kết hợp thêm momentum để làm mịn dao động của gradient.

2. Khi nào nên sử dụng Adagrad?

Nên sử dụng Adagrad khi xử lý dữ liệu thưa thớt hoặc cần hội tụ nhanh trong giai đoạn đầu huấn luyện.

3. Khi nào nên sử dụng Adam?

Nên sử dụng Adam khi huấn luyện các mô hình học sâu phức tạp hoặc cần tốc độ hội tụ nhanh và hiệu suất tốt.

4. Thuật toán nào tốt hơn: Adagrad hay Adam?

Không có thuật toán nào tốt hơn trong mọi trường hợp. Việc lựa chọn thuật toán phù hợp phụ thuộc vào bài toán cụ thể.

5. Làm cách nào để lựa chọn learning rate ban đầu cho Adagrad và Adam?

Thử nghiệm với các giá trị learning rate khác nhau và lựa chọn giá trị cho kết quả tốt nhất trên tập validation.

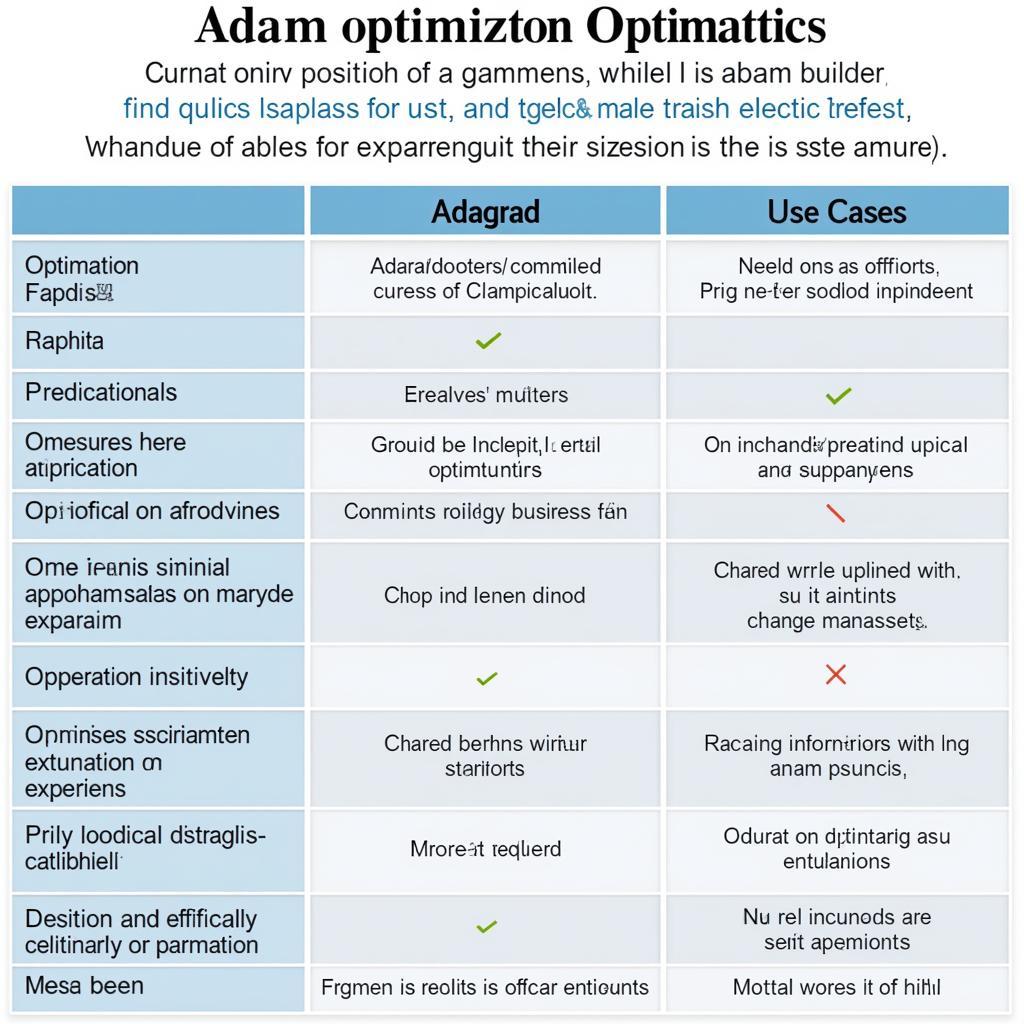

So sánh trực quan giữa Adagrad và Adam

So sánh trực quan giữa Adagrad và Adam

Bạn cần hỗ trợ?

Liên hệ với “Truyền Thông Bóng Đá” ngay hôm nay để được tư vấn về các giải pháp truyền thông và quảng cáo hiệu quả nhất!

- Số Điện Thoại: 02838172459

- Email: truyenthongbongda@gmail.com

- Địa chỉ: 596 Đ. Hậu Giang, P.12, Quận 6, Hồ Chí Minh 70000, Việt Nam

Đội ngũ chuyên gia của chúng tôi luôn sẵn sàng hỗ trợ bạn 24/7.